Google heeft een deep learning-algoritme ontwikkeld dat aan de hand van slechts de pixels in een afbeelding kan bepalen waar de foto is genomen. Zelf een foto van je huisdier of een selfie op vakantie zonder dat ze een geo-informatie bevatten. Het algoritme is het werk van Google-programmeur Tobias Weyand en twee mede-onderzoekers.

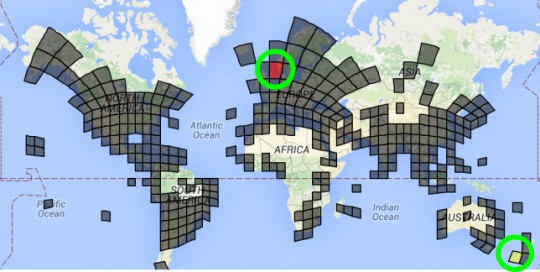

Deze maand publiceerde hij het onderzoek (pdf) waarin hij het algoritme, PlaNet genaamd, presenteert. Het team verdeelde een groot deel van de wereld in vlakjes, gebaseerd op het aantal foto’s dat binnen die vlakken zijn genomen. Meer foto’s betekent een groter vlak. Het algoritme werd getraind door foto’s met geodata. PlaNet probeert aan de hand van deze vlakken achter te de locatie te komen en berekent de kans dat een bepaalde foto ergens is genomen.

De foto van de Eiffeltoren is voor PlaNet een makkie. Met een fjord heeft hij al wat meer moeite en wijst hij twee mogelijke locaties aan. Met het strand in Californië heeft PlaNet nog veel moeite, hoewel de juiste locatie wel tussen zijn gok zit.

Voorheen hingen algoritmes die voorspellingen over de locatie probeerden te doen vaak af van gegevens die een mens ook zou gebruiken om een locatie te raden, zoals bouwstijl of de taal die in straatnamen of verkeersborden te lezen is. Uit 2,3 miljoen foto’s van Flickr wist het algoritme PlaNet 3,6 procent van de afbeeldingen op straatniveau te raden en van 10 procent de juiste stad. Bij meer dan een kwart van de foto’s wist hij het land te achterhalen en van bijna de helft het juiste continent.

Het algoritme werd uitgebreid zodat het zijn voorspelling ook maakte op afbeeldingen die het eerder had gezien, bijvoorbeeld omdat ze in hetzelfde album zaten. Het algoritme werd verder getraind met 490 miljoen foto’s geüpload op Google+. Van de 126 miljoen tests die daarna werden uitgevoerd, wist het zijn uitvoering op straatniveau met vijftig procent te verbeteren.